首次推出基于 Mamba 的生产级模型,提供一流的质量和性能。

一、Jamba是什么?

Jamba是由AI21 Labs推出的首个基于Mamba架构的生产级别的大语言模型,目前大部分的大模型(如GPT、Gemini 和 Llama)都是基于 Transformer 结构。而 Jamba 结合了 Mamba 结构化状态空间模型(SSM)和 传统Transformer 架构,兼具了高质量输出、高吞吐量和低内存占用的优点。该混合结构的模型提供了256K的上下文窗口,显著提升了处理长文本时的吞吐量和效率。

Jamba 以开放权重的形式发布,遵循Apache 2.0开源许可,鼓励社区进行进一步的研究和优化。目前,Jamba 目前作为研究模型发布,没有必要的商业用途保障。AI21 Labs 计划在未来几周内发布一个经过微调、更安全的版本。

世界上第一个基于 Mamba 的量产级模型。通过利用传统 Transformer 架构的元素增强Mamba结构化状态空间模型 (SSM) 技术,Jamba 弥补了纯 SSM 模型的固有局限性。它提供了 256K 上下文窗口,已经在吞吐量和效率方面展现了显着的进步——这只是这种创新混合架构的开始。值得注意的是,Jamba 在各种基准测试中均优于或与同尺寸级别的其他最先进型号相媲美。

二、Jamba的网站入口:

1、Jamba项目主页:

2、官方博客介绍:

https://www.ai21.com/blog/announcing-jamba

3、Hugging Face地址:

https://huggingface.co/ai21labs/Jamba-v0.1

三、Jamba的主要特点:

- SSM-Transformer混合架构:Jamba是首个采用Mamba SSM(结构化状态空间模型)与Transformer架构相结合的生产级模型,这种创新的混合架构旨在提升模型的性能和效率。

- 大容量上下文窗口:Jamba提供了256K的上下文窗口,这使得模型能够处理更长的文本序列,适用于更复杂的自然语言处理任务。

- 高吞吐量:相比于同等规模的Mixtral 8x7B模型,Jamba在处理长上下文时实现了3倍的吞吐量提升,可以更高效地处理大量数据。

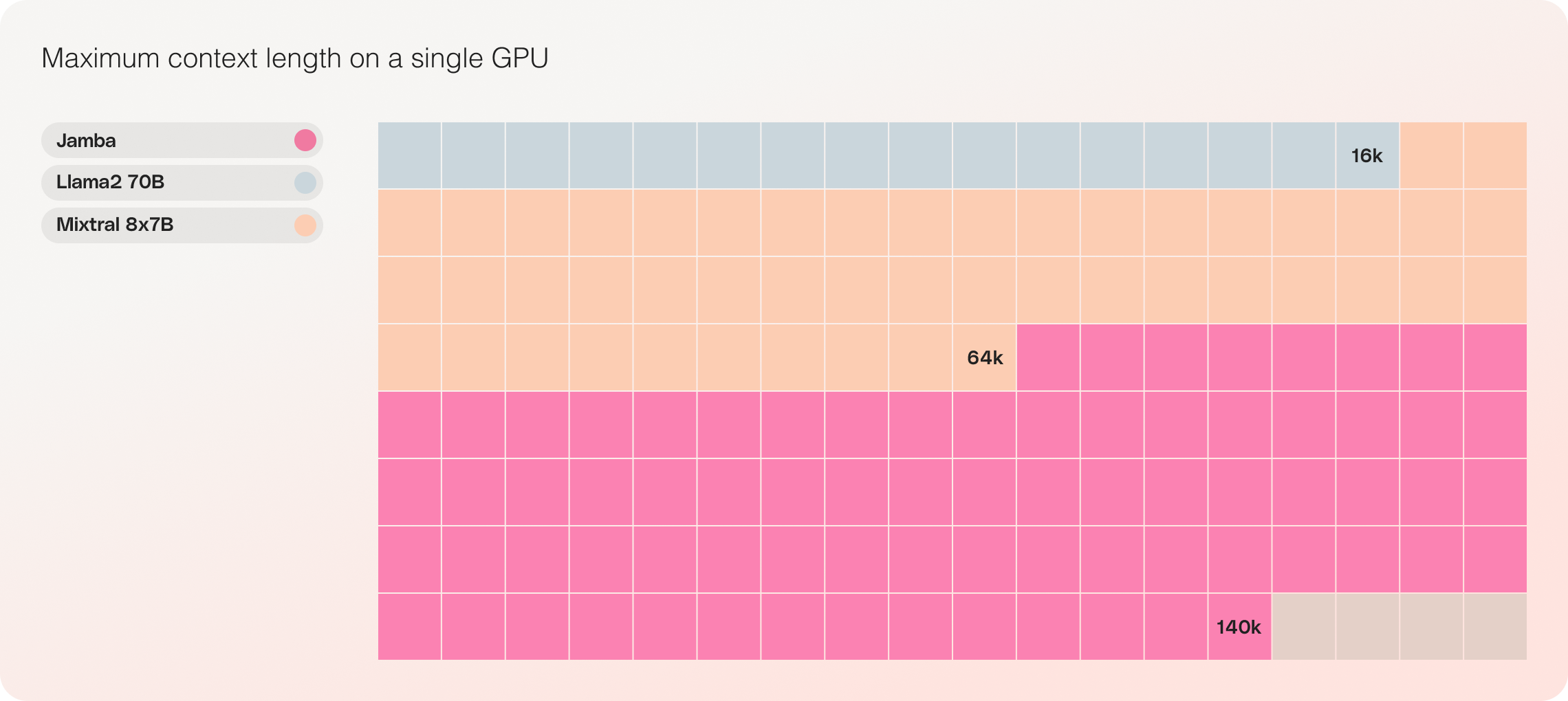

- 单GPU大容量处理:Jamba能够在单个GPU上处理高达140K的上下文,显著提高了模型的可访问性和部署的灵活性。

- 开放权重许可:Jamba的权重以Apache 2.0许可发布,为研究者和开发者提供了自由使用、修改和优化模型的权限,促进了技术的共享和创新。

- NVIDIA API集成:Jamba将作为NVIDIA NIM推理微服务在NVIDIA API目录中提供,使得企业开发者可以利用NVIDIA AI Enterprise软件平台轻松部署Jamba模型。

- 优化的MoE层:Jamba利用混合结构中的MoE(混合专家)层,在推理时只激活部分参数,提高了模型的运行效率和性能。

四、Jamba的技术架构:

要成功扩展 Jamba 的混合结构,需要进行多项核心架构创新。

如下图所示,AI21 的 Jamba 架构采用块和层方法,使 Jamba 能够成功集成两种架构。每个 Jamba 块包含一个注意力层或一个 Mamba 层,后跟一个多层感知器 (MLP),从而产生每八层中一个 Transformer 层的总体比例。

第二个功能是利用 MoE 来增加模型参数的总数,同时简化推理中使用的活动参数的数量,从而在计算需求没有相应增加的情况下获得更高的模型容量。为了最大限度地提高单个 80GB GPU 上的模型质量和吞吐量,我们优化了所使用的 MoE 层和专家的数量,为常见推理工作负载留下了足够的可用内存。

五、Jamba的吞吐量和效率:

Jamba 在吞吐量和效率等关键衡量指标上表现出色。虽然其初步性能已经达到了令人印象深刻的里程碑,但我们很高兴看到随着社区通过实验和优化进一步推动这项新技术,这些基准将如何继续改进。

1、效率

在长上下文中提供 3 倍的吞吐量,使其成为比 Mixtral 8x7B 等大小相当的基于 Transformer 的模型更高效的模型。

2、成本

Jamba可以在单个 GPU 上容纳 140K 上下文,与当前类似大小的其他开源模型相比,提供更多的部署和实验机会。